Darum geht es in dieser Blog-Serie:

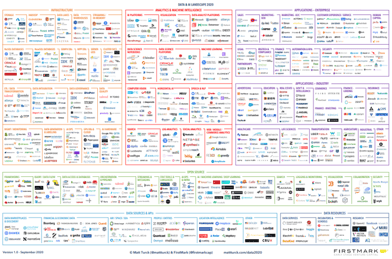

Tableau, Looker, Incuda, Power BI oder Supermetrics - irgendwelche Magie mit Daten machen sie alle und häufig steht Business Intelligence drauf, aber wo ist BI tatsächlich drin? Die Auswahl an Software Lösungen ist groß und seither ist es schwierig geworden, bei all dem Angebot einen Überblick zu behalten. Abhilfe schafft dieser Ratgeber in Form von 4 aufeinanderfolgenden Blogartikeln – basierend auf unserer umfassenden BI-zentrierten Beratungs- und Entwicklungstätigkeit im Online-Sektor. Für alle, die die Unterschiede verstehen wollen. Und speziell für Online-Händler.

Episodenverzeichnis

- Business Intelligence - sehen Sie das große Ganze. Das müssen Händler Ihrer BI-Entscheidung beachten

- Tableau vs. minubo - Business Intelligence Software im Vergleich

- Supermetrics vs. minubo - Business Intelligence Software im Vergleich

- Looker vs. minubo - Business Intelligence Software im Vergleich (coming soon)

Episode 1

Business Intelligence - sehen Sie das große Ganze

Das müssen Händler bei ihrer BI-Entscheidung beachten

Warum solltest Du dir als Händler überhaupt Gedanken um die Nutzung Deiner Daten machen? 1) Daten schaffen Transparenz, Messbarkeit und damit Steuerung 2) Daten bringen Erkenntnisse, um somit bessere Entscheidungen treffen zu können 3) Daten erlauben eine individuelle und gezielte Kundenansprache, Automatisierung und Personalisierung.

Soweit verstanden und vermutlich nichts Neues: der Zugang zu Daten, diese zu extrahieren, aufzubereiten und zu analysieren ist ein kritischer Faktor für den Erfolg eines Online-Händlers und seines Geschäftsmodells. Hört sich in der Theorie leichter an als in der Praxis, denn die immer größer werdenden Datenmengen erfordern IT-gestützte Systeme und Anwendungen, um einen Überblick und Einblick in die Prozesse und Unternehmensdaten zu erhalten. Häufig ist der Zugang zu relevanten Daten beschränkt, da sie in unterschiedlichen Systemen, Quellen und Anwendungen, somit in isolierten unternehmensinternen Silos vorliegen, und dadurch nicht zentral zur Verfügung stehen. Kommt das Ihnen bekannt vor?

Jetzt gibt es zwei Möglichkeiten: Du kannst entweder die beschränkte Funktionalität Deiner Silos verwenden und in Kauf nehmen, dass Du weder konsolidierte noch aussagekräftige Daten zu Gesicht bekommst oder Du entscheidest dich für eine moderne Business Intelligence Lösung (BI), die für ganzheitliche Datenanalyse, Reporting und Dashboarding eine entsprechende Lösung bietet.

Das Big Data Ökosystem

Unterschiedliche Technologien, Kategorien und Unternehmen soweit das Auge reicht. Sie alle machen irgendwelche Magie mit Daten und häufig steht Business Intelligence drauf, aber wo ist BI tatsächlich drin und nicht nur schmückendes Buzzword? Und wer kann da noch den Überblick behalten? Oft gibt es Überschneidungen bei den Software Lösungen, aber meist haben Datentechnologien ihre ganz eigenen Einsatzbereiche, Anforderungen, Werkzeuge und Bestimmungen. Lassen Sie uns in dieser Blog-Serie also ein Verständnis für dieses Ökosystem entwickeln, verstehen welche Bereiche die einzelnen Software-Anbieter abdecken, was sie unterscheidet und für welche Anforderungen sie tatsächlich gemacht sind. Dafür schauen wir uns zunächst an, welche Komponenten eine klassische Business Intelligence Infrastruktur beinhaltet und wie diese aufgebaut ist.

Unterschiedliche Technologien, Kategorien und Unternehmen soweit das Auge reicht. Sie alle machen irgendwelche Magie mit Daten und häufig steht Business Intelligence drauf, aber wo ist BI tatsächlich drin und nicht nur schmückendes Buzzword? Und wer kann da noch den Überblick behalten? Oft gibt es Überschneidungen bei den Software Lösungen, aber meist haben Datentechnologien ihre ganz eigenen Einsatzbereiche, Anforderungen, Werkzeuge und Bestimmungen. Lassen Sie uns in dieser Blog-Serie also ein Verständnis für dieses Ökosystem entwickeln, verstehen welche Bereiche die einzelnen Software-Anbieter abdecken, was sie unterscheidet und für welche Anforderungen sie tatsächlich gemacht sind. Dafür schauen wir uns zunächst an, welche Komponenten eine klassische Business Intelligence Infrastruktur beinhaltet und wie diese aufgebaut ist.

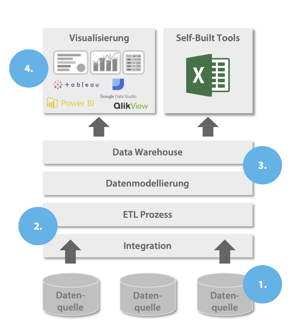

Architektur einer Business Intelligence Lösung

Um die verschiedenen Software-Anbieter gemäß ihrer Funktionalität einordnen zu können, hilft ein generelles Verständnis über den Aufbau und die unterschiedlichen Komponenten einer Business Intelligence Lösung.

Grundsätzlich benötigt eine BI Infrastruktur folgende 4 Ebenen, wovon jede Ebene eine bestimmte Aufgabe übernimmt.

- Datenquellen

- ETL-Prozess

- Data Warehouse

- Datenanalyse und -visualisierung

Diese Ebenen übernehmen unterschiedliche Aufgaben, wie Daten zu sammeln, zu speichern, zu analysieren und zu visualisieren. Sie können entweder mit Hilfe einer standardisierten Komplettlösungen - wie in unserem Beispiel mit der Business Intelligence Lösung minubo - oder unterschiedlichen Teillösungen realisiert werden. Ein entscheidender Faktor für die Einordnung der zahlreichen Software-Anbieter ist daher das Verständnis des Aufbaus und der Funktion einer BI-Architektur, die wir im folgendem detailliert betrachten:

Ebene 1: Datenquellen (sammeln)

Ebene 1: Datenquellen (sammeln)

Die erste Ebene, die Datenquellen, gehören nicht direkt zum BI-System. Sie enthalten die isolierten Rohdaten, welche dezentral, redundant und unverknüpft in den einzelnen Anwendungen und Tools des Unternehmens verteilt vorliegen. Dabei kann es sich beispielsweise um transaktionale oder operative Daten, wie Bestellungen, Web-Sessions, Kampagnen-, Touchpoint-Daten, Kunden- und Produkt-Stammdaten aus CRM, Shop-System, Webtracking, ERP oder Warenwirtschaft handeln. Aber auch externe Datenquellen, wie beispielsweise Online-Datenbanken oder Markt- und Wettbewerbsdaten, können zu ihnen zählen.

Ebene 2: ETL (integrieren)

In der Ebene 2 geht es um die Datenintegration. Diese geschieht mit Hilfe des sogenannten ETL Prozesses (Extract, Transform and Load), der die Informationen aus den Quellsystemen herausholt und über Schnittstellen in eine zentrale Datenbank oder ein Data Warehouse, dem sogenannten Zielspeicher, integriert.

Dieser ETL Prozess ist in drei Phasen unterteilt. 1) Die Daten werden aus den unterschiedlichen Vorsystemen extrahiert und so organisiert, dass sie in ihrem Format und ihrer Struktur konsistent sind (Extract). 2) Im nächsten Schritt werden die Daten von der Quell- in die Zieldatenbank transformiert, bereinigt und in einem Standardformat zur Verfügung gestellt (Transform). Das sorgt dafür, dass die Daten in korrekter Form vorliegen und im letzten Schritt 3) in die Zieldatenbank oder das Data Warehouse integriert (Load) und für den einfachen Zugriff und die weitere Analyse bereitgestellt werden.

Die Rolle eines ETL-Prozesses ist für Business Intelligence von großer Bedeutung. Durch ETL wird die Verfügbarkeit und der Wert von Daten und deren Qualität deutlich erhöht. Datensilos werden überwunden, die zuvor getrennten Datenquellen müssen somit nicht mehr händisch verknüpft werden, sondern liegen konsolidiert an einem zentralen Ort vor. Die Rohdaten werden in wertvolle Informationen transferiert, von Fehlern bereinigt und in Standards etabliert, sodass die Daten verlässlich auswertbar sind und somit unternehmensweit als Basis für datengetriebene Entscheidungen dienen können. Die Erstellung eines ETL-Prozesses erfordert einen kontinuierlichen Aufwand, da sich sowohl die Quellsysteme als auch die Ausgabeanforderungen ständig ändern und wachsen.

Ebene 3: Data Warehouse (speichern)

Eine der fundamentalen Architektur-Komponenten einer Business Intelligence Lösung ist die Datenspeicherung - das Data Warehouse (DWH). Das Data Warehouse ist ein Massenspeicher, der dafür optimiert ist große Datenmengen für analytische Datenabfragen performant zur Verfügung zu stellen. Die Performance eines DWHs zeichnet sich vor allem durch die Abfragegeschwindigkeit aus. Sehr variable Datenabfragen können für Analysezwecke, mit geringer Ausführungszeit, hochperformant ausgeführt werden.

Ein Data Warehouse ermöglicht somit eine globale Sicht und den Zugang auf einen konsistenten Datenbestand und dadurch Abfragen auf alle benötigten Detail- und Aggregationsebenen, ein Schlüssel für die wirklich wertstiftende Arbeit mit Daten. Snowflake, oder Exasol, gehören zu den Lösungen, die das Ziel verfolgen, die Datenlandschaft eines Unternehmens in ein flexibles Data Warehouse zu transformieren und sie somit für Analysen und als betriebswirtschaftliche Entscheidungshilfe zur Verfügung zu stellen.

Ebene 4: Datenanalyse & -visualisierung (analysieren)

In der Regel greifen Anwender nicht direkt auf die Daten eines Data Warehouses zu, sondern nutzen Drittsysteme zur Datenvisualisierung und -analyse, um Entwicklungen, Verteilungen, Trends und Zusammenhänge auf einen Blick leicht erfassen zu können. Daten werden so zu Erkenntnissen und praktisch umsetzbaren Maßnahmen, die Unternehmen und Mitarbeitern helfen, stärker datengesteuert zu arbeiten.

Ein Frontend mit einfach zu bedienenden Werkzeugen für das operative Personal ist daher eine zentrale Anforderung an moderne BI, damit die gestellten Business-Fragen, auf Basis der vorliegenden Daten, schnell, möglichst genau und vor allem eigenständig beantwortet werden können. Daten sollten von den Fachabteilungen im Self-Service abgefragt werden können und nicht wie bei der traditionellen BI üblich, zentral bei der IT- oder dem Analysten-Team angefragt werden müssen, um so Wartezeiten zu vermeiden und datengetriebene Entscheidungsfindung schnell und ohne Umwege zu ermöglichen.

Dafür steht eine Vielzahl von Software-Anbietern auf dem Markt zur Verfügung. Neben Tableau, Google Data Studios und QlikView ist Power BI vermutlich eines der bekanntesten Visualisierungstools. Diese Lösungen bieten zahlreiche Möglichkeiten, wenn es um die Erstellung übersichtlicher Reportings, Dasboards und Ad-hoc-Analysen geht. Um diese Tools jedoch zielführend einzusetzen und ihre Stärken tatsächlich zu nutzen, bedarf es einer soliden Dateninfrastruktur, denn: der Output von diesen Tools ist eben nur so gut wie der Input.

Wie komme ich nun zu meiner Business Intelligence Lösung?

Die Bestandteile einer Business Intelligence Lösung sind jetzt klar definiert, eine Frage bleibt jedoch unbeantwortet: wie kann ich so eine BI-Infrastruktur in meinem Unternehmen etablieren? Hier gibt es zwei Lösungen 1) ich kaufe eine “Business Intelligence Komplettlösung”, also eine standardisierte Software - wie die Business Intelligence Lösung minubo - die alle oben genannten Ebenen abdeckt oder 2) ich baue mir einen eigenen Business Intelligence Stack mit individuellen Komponenten (gekauft oder auch selbst gebaut). Lassen Sie uns die beiden Möglichkeiten - am Beispiel von minubo und einem mit Tableau gebauten Tech Stack - beleuchten und anhand von einigen Kriterien näher auf die Vor- und Nachteile eingehen.

| Business Intelligence Komplettlösung | zusammengesetzter Business Intelligence Stack | |

|

Datenmodellierung |

Durch ein integriertes Best Practice Datenmodell und vordefinierten eCommerce Kennzahlen, fällt aufwendige Datenmodellierung und langwieriger Definitionsaufwand weg. Zusammen mit Branchen-Experten wie Project A, Spryker oder dem bevh, dem Händlerbund, hat minubo ein umfassendes Modell aus Handelskennzahlen, KPI-Sets und Report-Vorlagen erarbeitet und der Öffentlichkeit – vor allem natürlich den Handelsunternehmen selbst – zur Verfügung gestellt. Dieses findest Du hier. |

|

|

Kontrolle über Setup |

Kein direkter Tech-Zugriff, aber schnelle Umsetzung individueller Anforderungen mit dem Software-Anbieter möglich - oft sogar schneller, als interne Zyklen. |

Volle Kontrolle über Support, Wartung, Setup-Anpassung und -Erweiterung sowie Weiterentwicklung |

|

Kompetenzaufbau |

Wissensaufbau durch eingebaute Best Practices, breite Dokumentation sowie dedizierte Kundenbetreuung und -beratung. |

Aufbau von Expertenwissen und Dateninfrastruktur-Kompetenz während des Entwicklungsprozesses; Verlustrisiko, da Wissen von einzelnen Personen abhängt |

|

Kontinuität der Leistungserweiterung |

Kontinuierliche Entwicklung neuer Features (angefragt und proaktive, die unerwartete Möglichkeiten eröffnen) und Tech-Weiterentwicklung nach modernsten Standards |

Entwicklungsressourcen wahrscheinlich nicht projektexklusiv, deshalb Weiterentwicklung nur auf Anfrage (nicht proaktiv) - und mit zu erwartenden Verzögerungen. |

|

Skaleneffekte |

Schnittstellen mit einmaligen Entwicklungsaufwand werden von vielen Kunden genutzt. Diese sowie die Kosten rechenintensiver Analysen können somit geteilt werden. |

Keine |

|

Zeit bis zur produktiven Nutzung: |

Onboarding in nur wenigen Wochen; dann sukzessive Setup-Anpassungen/-Erweiterungen, wenn benötigt |

Konzept, Entwicklung und Testing für das initiale Setup dauert im Allgemeinen mindestens zwei Jahre |

|

Kosten |

Im 5-Jahres-Zeithorizont können die Kosten sieben mal geringer ausfallen, als beim Inhouse BI-Projekt. Details finden Sie hier. |

Im 5-Jahres-Zeithorizont bei einfacher Eigenbau-BI (Aufbau und Wartung) >2M € für Personal- und Tech-Kosten |

|

Tech-Investitionen |

Tech-Kosten signifikant reduziert aufgrund von Multi-Mandanten-Skaleneffekten der zentralen Infrastruktur |

Vollständige Infrastruktur muss bezahlt und gewartet werden |

|

Ressourcenaufwand (Personal) |

Keiner |

Projekt-Personal (Business & BI/Analytics) und Dev/DevOps-Personal (initiale Entwicklung, Hosting, laufenden Wartung) |

|

Investitionsrisiko |

Keine Kapitalbindung durch eigenes Personal / Infrastruktur. Kündigung jährlich möglich, keine bleibenden Kosten / Legacy-Setup |

Große Investitionen in eigenes Personal und Infrastruktur muss getätigt werden - führt zu hoher Kapitalbindung |

|

Usability |

Durch einen intuitiven Datenzugriff kann jeder Mitarbeiter im Self-Service selbstständig und unabhängig auf relevante Daten zugreifen. |

Häufig müssen IT-ler und Analysten auf Anfrage Daten für Business-Stakeholder extrahieren. Der Entwicklungsaufwand wird deutlich erhöht, bzw. der Stack durch diverse Spezial-Tools für einzelne Fachbereiche ergänzt, wenn breiter Self-Service für den Nutzer ermöglicht werden sollen. |

Der Weg durch die Tool-Landschaft

So weit so gut. Wir wissen jetzt, dass die Datensammlung, Integration und Bereitstellung Voraussetzung für eine erfolgreiche Business Intelligence Lösung sind. Und wir wissen auch, dass diese BI-Infrastruktur entweder über eine standardisierte Business Intelligence Komplettlösung oder in einem Inhouse-Projekt über einen individuell zusammengestellten “Business Intelligence Stack” zur Verfügung gestellt werden kann. Dabei wurde deutlich, dass der Einkauf einer BI-Komplettlösung für Händler oft die besser Wahl scheint. Zwar gibt es beim Inhouse-Projekt Vorteile bei der individuellen Anforderungsabdeckung, der Kontrolle über das Setup und dem in-house Kompetenzaufbau, jedoch wurde auch deutlich, dass ein solches Projekt meist deutlich länger, teurer, risikoreicher und herausfordernder in der Umsetzung wird. Für Leser, die bereits Software im Einsatz haben, könnte eine Kombination aus standardisierter BI und individuellem Tech-Stack ein entsprechendes Szenario sein.

Wie auch immer die Wahl des Infrastruktur-Setups ausfällt, die wichtigste Frage bleibt bestehen: welche Technologie deckt welche Anforderung nun am besten ab? Und wie unterscheiden sich diese überhaupt voneinander - denn nicht überall wo BI drauf steht, steckt BI drin? Zeit also, Tableau, Supermetrics, Looker, DynamicAction und PowerBI einmal genauer unter die Lupe zu nehmen:

Artikel 2) Business Intelligence Software im Vergleich - Tableau vs. minubo

Solltest Du dich doch für den Ansatz Marke Eigenbau entschieden haben, dann kann ich Dir folgende Lektüre ans Herz legen: Die Commerce Intelligence Blaupause. Diese beschreibt die grundsätzliche Herangehensweise an ein BI-Projekt bzw. zu dessen wichtigsten Erfolgsfaktoren.

nach Wunsch auch mit Videocall

nach Wunsch auch mit Videocall